회사 내부 인트라넷 환경에서 생성형 AI를 운영하기 위한 필수 인프라 구성 요소

최근 기업들이 생성형 AI(Generative AI)를 도입해 내부 업무 자동화, 데이터 분석, 맞춤형 솔루션 개발 등 다양한 이점을 활용하려는 시도가 늘고 있습니다. 특히 외부 네트워크로부터의 보안 위협을 최소화하기 위해 생성형 AI를 회사 내부 인트라넷 환경에서 운영하려는 기업들이 많아지고 있습니다. 이 글에서는 생성형 AI를 사내에서 원활히 운영하기 위해 필요한 주요 인프라 구성 요소를 자세히 살펴보겠습니다.

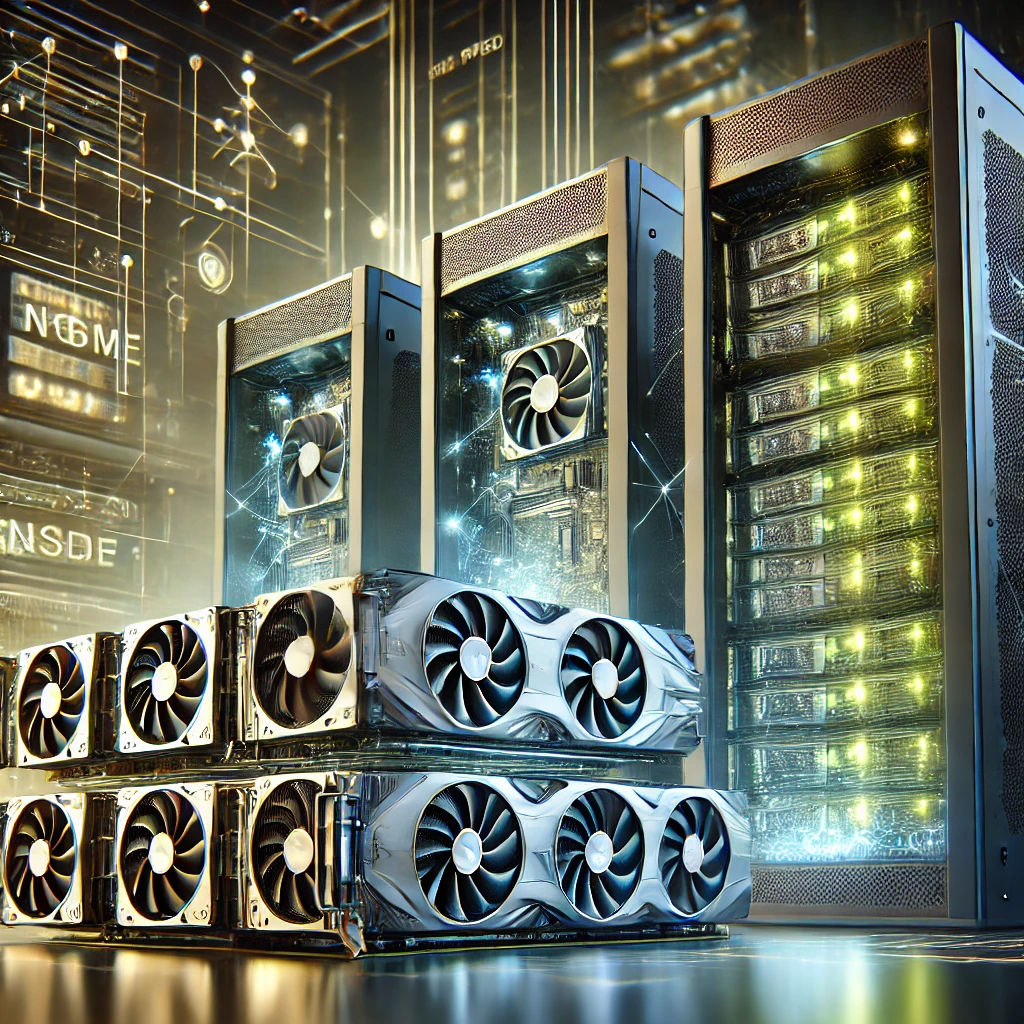

1. 고성능 하드웨어 구성

생성형 AI는 대규모 데이터를 처리하고 복잡한 모델을 학습 및 실행해야 하므로 고성능 하드웨어가 필수적입니다. 이를 위해 다음과 같은 요소를 준비해야 합니다.

GPU(그래픽 처리 장치) 기반 서버

생성형 AI는 특히 딥러닝 모델의 훈련과 추론에서 고성능 GPU가 필수적입니다. NVIDIA A100, H100과 같은 AI 워크로드에 최적화된 GPU는 병렬 연산을 빠르게 수행하여 모델의 학습 속도를 높이고 실시간 데이터 처리 성능을 제공합니다.

고성능 스토리지

생성형 AI는 대규모 데이터 세트를 다루므로 빠르고 안정적인 스토리지 시스템이 필요합니다. 이를 위해 NVMe(Non-Volatile Memory Express) SSD와 같은 고속 스토리지와 데이터 분산 저장 기술을 활용하여 병목현상을 방지할 수 있습니다. 또한, RAID(Redundant Array of Independent Disks) 구성으로 데이터 안정성을 높이는 것도 중요합니다.

확장 가능한 서버 아키텍처

AI 프로젝트는 점진적으로 확장될 가능성이 높기 때문에, 클러스터링(clustering)을 지원하는 서버 환경을 구축해야 합니다. CPU와 GPU의 병렬 확장이 용이하도록 서버를 설계하고, 필요에 따라 노드를 추가할 수 있는 인프라가 필요합니다.

2. 소프트웨어 스택과 플랫폼 구성

고성능 하드웨어 위에서 원활히 작동할 수 있는 소프트웨어 스택과 플랫폼이 필요합니다. 다음은 생성형 AI를 사내 인트라넷 환경에서 운영하기 위한 핵심 소프트웨어 요소들입니다.

AI 프레임워크

생성형 AI 모델을 개발하고 실행하기 위해 TensorFlow, PyTorch, JAX와 같은 딥러닝 프레임워크를 설치해야 합니다. 이들 프레임워크는 GPU 가속을 지원하며, 대규모 모델 학습과 추론에 필요한 기능을 제공합니다.

컨테이너 기반 환경

Docker와 Kubernetes 같은 컨테이너 기술을 활용하여 생성형 AI 애플리케이션을 배포 및 관리합니다. 이를 통해 환경 설정을 표준화하고, 시스템의 유연성과 확장성을 확보할 수 있습니다. Kubernetes는 특히 여러 서버에 걸쳐 워크로드를 배포하는 데 적합합니다.

데이터 관리 플랫폼

효율적인 데이터 관리를 위해 Hadoop, Apache Spark, 또는 데이터베이스 솔루션(예: PostgreSQL, MongoDB)을 도입합니다. 이러한 플랫폼은 데이터를 효과적으로 저장하고, 분석 및 처리하는 데 도움을 줍니다. 생성형 AI 모델의 학습 데이터는 정제와 구조화가 필요하므로, 데이터 전처리를 지원하는 도구도 중요합니다.

보안 소프트웨어

인트라넷 내의 데이터와 시스템을 보호하기 위해 보안 소프트웨어가 필요합니다. 데이터 암호화, 사용자 인증, 권한 관리 등의 기능을 제공하는 솔루션을 도입해야 하며, OpenVPN 또는 프록시 서버와 같은 네트워크 보안 도구도 필요합니다.

3. 데이터 준비 및 관리

생성형 AI의 성능은 학습 데이터의 질과 양에 크게 좌우됩니다. 따라서 데이터를 효과적으로 준비하고 관리하는 인프라가 필수적입니다.

데이터 수집 및 정제

사내에서 생성형 AI를 활용하기 위해 필요한 데이터를 수집하고, 데이터 전처리를 수행해야 합니다. 이를 위해 데이터 클리닝, 중복 제거, 정규화 등의 과정을 지원하는 ETL(Extract, Transform, Load) 도구를 활용할 수 있습니다. 예를 들어 Apache Nifi 또는 Talend와 같은 도구가 유용합니다.

데이터 레이크(Data Lake)

대규모 비정형 데이터를 저장하기 위해 데이터 레이크를 구축해야 합니다. 데이터 레이크는 Hadoop 기반 HDFS 또는 Amazon S3와 같은 스토리지를 활용하여 유연한 데이터 저장소를 제공합니다. 이러한 데이터는 모델 학습과 평가에 활용됩니다.

데이터 익명화 및 보안

개인 정보 보호 규정을 준수하기 위해 데이터 익명화 및 암호화 기술을 도입해야 합니다. 민감한 데이터를 활용하는 경우, 개인정보 식별자를 제거하거나 가명화 처리하여 데이터의 안전성을 보장할 수 있습니다.

실시간 데이터 처리

Kafka 또는 Apache Flink와 같은 실시간 데이터 스트리밍 플랫폼을 통해 생성형 AI 모델이 실시간 데이터를 처리할 수 있도록 해야 합니다. 이러한 도구는 AI가 최신 데이터를 기반으로 예측 및 생성 작업을 수행할 수 있게 합니다.

4. 네트워크와 보안 구성

인트라넷 환경에서 생성형 AI를 운영할 때, 네트워크 인프라와 보안은 매우 중요합니다. 안정적이고 안전한 네트워크 구성이 필수적입니다.

고속 네트워크

AI 모델의 학습과 추론은 대규모 데이터 전송이 필요하므로, 고속 네트워크가 필수입니다. 최소 10Gbps 이상의 네트워크 환경을 구축하고 , 데이터 전송 속도를 높이기 위해 로드 밸런싱과 네트워크 최적화를 도입해야 합니다.

내부 방화벽과 네트워크 분리

내부 시스템을 보호하기 위해 방화벽과 네트워크 분리(네트워크 세그멘테이션)를 설정합니다. 이를 통해 각 부서 또는 작업 단위 간의 네트워크 접근을 제어하고, 보안 위협을 줄일 수 있습니다.

사용자 인증 및 접근 제어

시스템 접근 권한을 엄격히 관리하기 위해 SSO(Single Sign-On), MFA(Multi-Factor Authentication)와 같은 보안 인증 솔루션을 도입해야 합니다. 이를 통해 내부 사용자가 AI 시스템에 안전하게 접근할 수 있도록 보장합니다.

암호화 통신

네트워크 내에서 전송되는 데이터를 보호하기 위해 TLS/SSL 암호화를 적용합니다. 이를 통해 데이터 전송 중 발생할 수 있는 보안 위협을 최소화할 수 있습니다.

5. 결론

회사 내부 인트라넷 환경에서 생성형 AI를 성공적으로 운영하기 위해서는 고성능 하드웨어, 최적화된 소프트웨어 스택, 데이터 관리 인프라, 그리고 철저한 보안 구성이 필수적입니다. 이를 통해 기업은 AI 기술을 안전하고 효율적으로 활용하여 업무 자동화와 생산성 향상을 달성할 수 있습니다. 특히, 이러한 인프라 구성은 초기 투자 비용이 크지만 장기적으로 기업의 경쟁력을 강화하는 데 크게 기여할 것입니다.

[회사 내부 인트라넷 환경에서 생성형 AI를 운영하기 위한 필수 인프라 구성 요소] 요약

생성형 AI를 사내에서 효과적으로 운영하기 위해서는 고성능 하드웨어, 딥러닝 프레임워크 및 데이터 관리 플랫폼, 보안 네트워크 등의 인프라가 필요합니다. 이는 안정적인 AI 운영 환경을 제공하며, 기업의 디지털 전환을 가속화하는 데 기여할 것입니다.

1. 고성능 하드웨어 구성

- GPU 기반 서버: 딥러닝 워크로드를 위한 고성능 처리.

- 고속 스토리지: NVMe SSD를 통한 데이터 처리 속도 향상.

- 확장 가능한 서버: 클러스터링 지원으로 유연한 확장.

2. 소프트웨어 스택

- AI 프레임워크: PyTorch, TensorFlow 등.

- 컨테이너 환경: Docker 및 Kubernetes를 활용한 관리.

- 데이터 관리: Apache Spark, 데이터베이스 솔루션.

3. 데이터 관리

- 데이터 레이크: 비정형 데이터 저장 및 관리.

- 데이터 익명화: 개인정보 보호를 위한 암호화.

- 실시간 데이터 처리: 스트리밍 플랫폼 활용.

4. 네트워크와 보안

- 고속 네트워크: 10Gbps 이상의 속도 제공.

- 사용자 인증: SSO 및 MFA 도입.

- 암호화 통신: TLS/SSL을 통한 데이터 보호.

결론

적절한 인프라를 구축하면 생성형 AI가 회사 내부에서 안전하고 효율적으로 운영될 수 있으며, 기업의 디지털 혁신과 경쟁력을 강화하는 데 중요한 역할을 합니다.

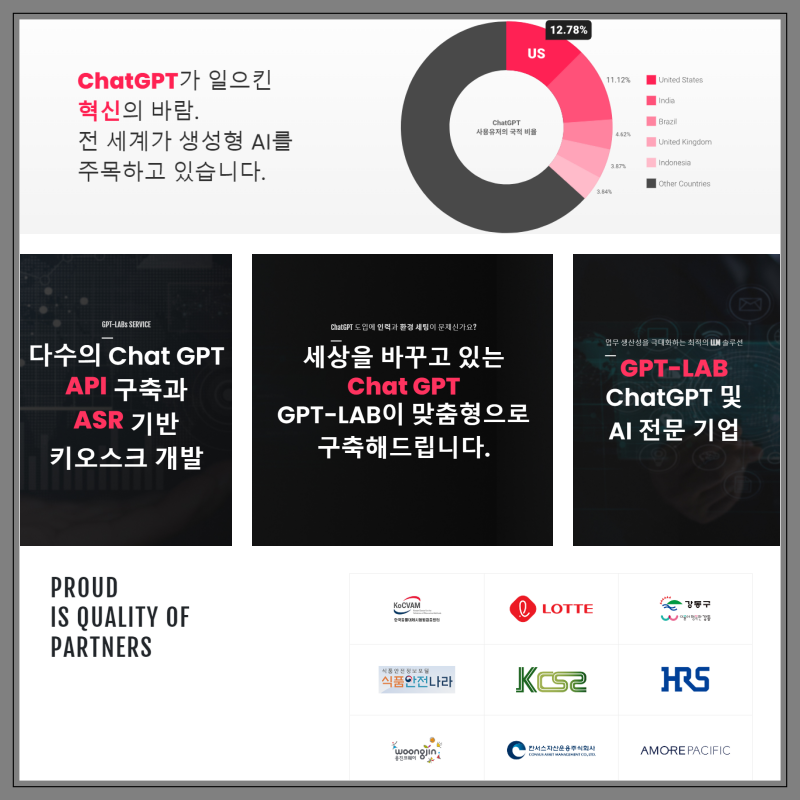

생성형AI (CHAT-GPT 등) 전문 기업 셈틀컴퍼니 https://gpt-lab.kr/

ChatGPT, 생성형AI, GENERATIVE AI, AI개발, 인공지능개발, 인공지능솔루션, 인공지능솔루션 개발, 인공

ChatGPT, 생성형AI, GENERATIVE AI, AI개발, 인공지능개발, 인공지능솔루션, 인공지능솔루션 개발, 인공지능키오스크, GPT랩, GPTLAB, 챗GPT

www.gpt-lab.kr